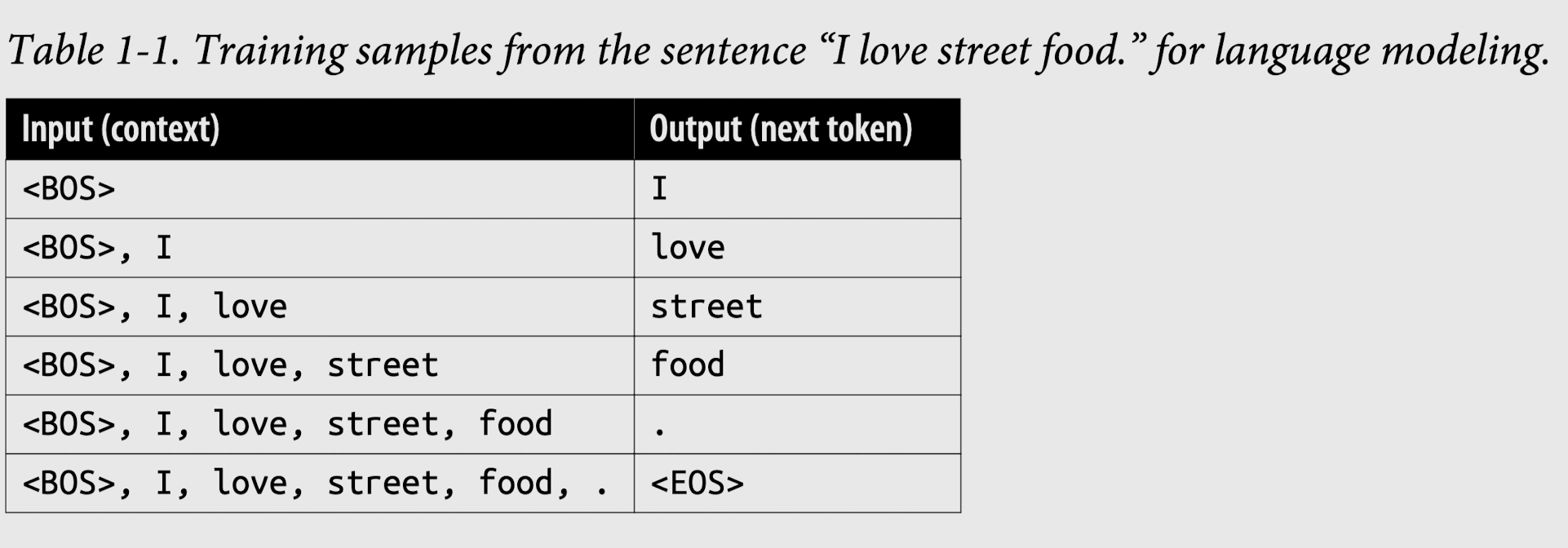

Self-supervision helps overcome the data labeling bottleneck. In self-supervision, instead of requiring explicit labels, the model can infer labels from the input data. Language modeling is self-supervised because each input sequence provides both the labels (tokens to be predicted) and the contexts the model can use to predict these labels. For

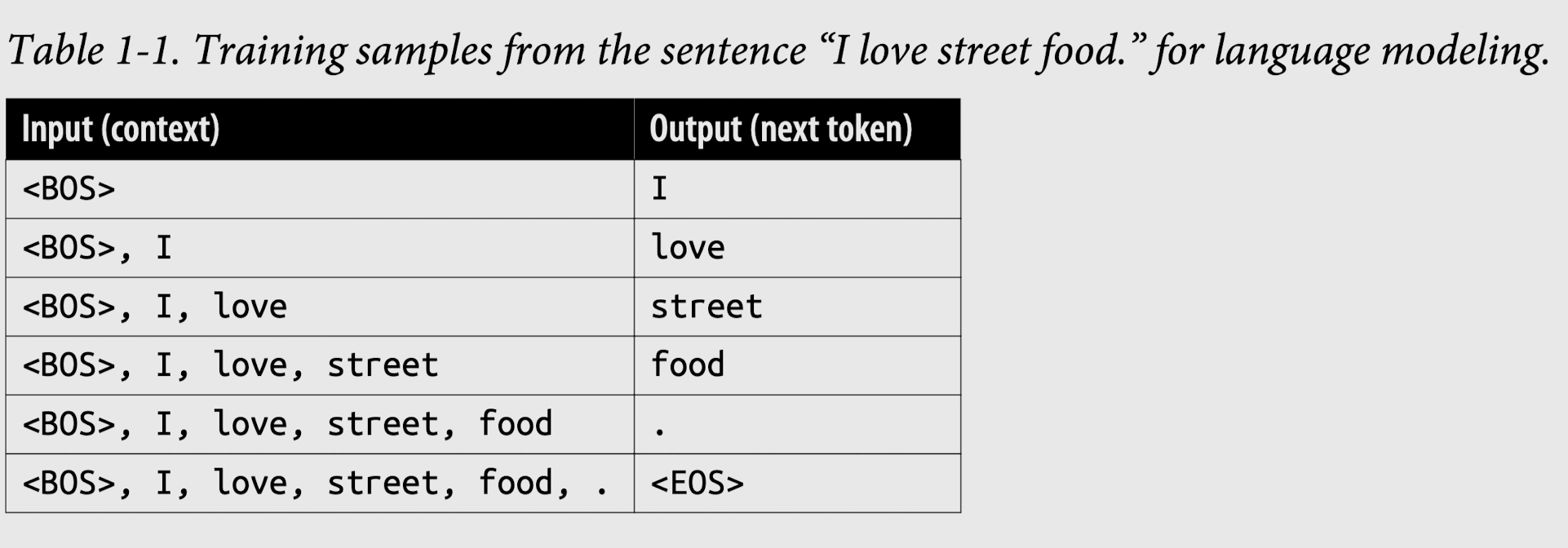

y marcan el inicio y el final de una secuencia. Estos marcadores son necesarios para que un modelo de lenguaje funcione con varias secuencias. Cada marcador se trata típicamente como un solo token especial por el modelo. El marcador de fin de secuencia es especialmente importante, ya que ayuda a los modelos de lenguaje a saber cuándo terminar sus respuestas.